website:https://kairaaiv2.netlify.app

Kaira-Turkish-Gemma-9B-T1 (GGUF)

Yayıncı: Umut Kökgöz (@umutkkgz)

Bu repo, ytu-ce-cosmos/Turkish-Gemma-9b-T1 taban modeli üzerine özel olarak eğitilmiş, yüksek performanslı Türkçe sohbet ve talimat takip modelinin GGUF formatını içerir. Model, yerel bilgisayarlarda (CPU veya GPU destekli) minimum kurulumla ve yüksek hızda çalışacak şekilde optimize edilmiştir.

🚀 En Kolay Kurulum: Ollama ile 2 Adımda Çalıştırın Bu modeli bilgisayarınızda çalıştırmanın en kolay ve tavsiye edilen yolu Ollama kullanmaktır. Ollama, macOS, Windows ve Linux üzerinde tek tıkla kurulum imkanı sunar.

Adım 1: Ollama'yı Yükleyin

Eğer bilgisayarınızda Ollama yüklü değilse, resmi web sitesinden saniyeler içinde indirip kurun:

➡️ https://ollama.com/download

Adım 2: Kaira Modelini Bilgisayarınıza Tanıtın

Aşağıdaki adımları takip ederek Kaira'yı kendi kişiliği ve en iyi performans ayarlarıyla bilgisayarınıza kalıcı olarak kaydedin.

Model Dosyasını İndirin

Bu reponun "Files and versions" sekmesinden sisteminize en uygun GGUF dosyasını indirin. Hangi modeli seçeceğinizden emin değilseniz, aşağıdaki tabloya göz atın.

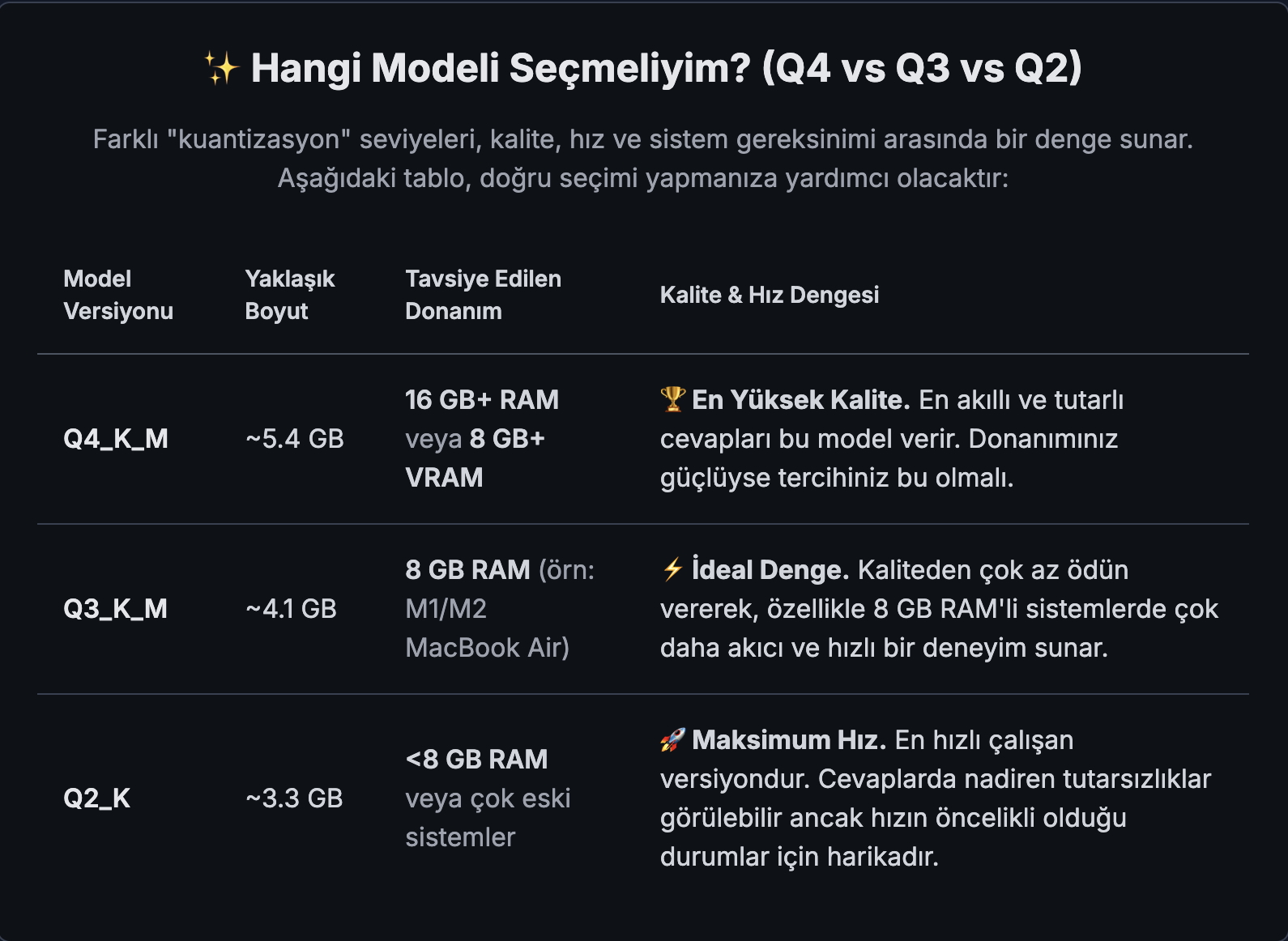

Hangi Modeli Seçmeliyim? (Q4 vs Q3 vs Q2)

Farklı "kuantizasyon" seviyeleri, kalite, hız ve sistem gereksinimi arasında bir denge sunar. Aşağıdaki resimli tablo, doğru seçimi yapmanıza yardımcı olacaktır:

Modelfile Oluşturun

İndirdiğiniz .gguf dosyasıyla aynı klasörün içine, Modelfile adında (uzantısız) bir dosya oluşturun ve aşağıdaki içeriği içine yapıştırın. Bu dosya, modelimizin kimliğini ve çalışma ayarlarını belirleyen bir tariftir.

ÖNEMLİ: FROM satırındaki dosya adını, indirdiğiniz versiyonla (Q4, Q3 veya Q2) güncellemeyi unutmayın!

Temel alınacak yerel GGUF model dosyasını belirtir.

FROM ./kaira-turkish-gemma-9b-t1.Q4_K_M.gguf

--- PERFORMANS PARAMETRELERİ ---

Apple Silicon (M1/M2/M3) veya NVIDIA/AMD GPU'lar için -1 değeri,

"mümkün olan TÜM katmanları GPU'ya yükle" anlamına gelir.

Bu, en yüksek performansı sağlar.

PARAMETER num_gpu -1 PARAMETER num_thread 8 # Kullanılacak CPU çekirdeği sayısı

--- MODEL DAVRANIŞ PARAMETRELERİ ---

PARAMETER num_ctx 4096 # Modelin hafıza (bağlam) penceresi PARAMETER temperature 0.7 # Yaratıcılık seviyesi PARAMETER top_p 0.9 # Kelime seçim hassasiyeti PARAMETER repeat_penalty 1.05 # Tekrarı önleme cezası

--- MODEL KİMLİĞİ VE ŞABLONU ---

TEMPLATE: Modelin sohbeti nasıl anlayacağını belirleyen format.

TEMPLATE """{{- range .Messages -}}{{ .Role }} {{ .Content }} {{- end -}}model

SYSTEM: Modele her sohbetin başında verilecek olan gizli talimat.

SYSTEM """Sen Kaira, yardımsever bir Türk yapay zeka asistanısın. Cevapların her zaman Türkçe, net, ve anlaşılır olmalı. Kullanıcıya daima dostça ve saygılı bir şekilde hitap et. Bilgilerinin bir kesim tarihine dayalı olduğunu ve en güncel olayları bilemeyebileceğini unutma."""

Modeli Oluşturun ve Çalıştırın Terminali (veya Windows'ta PowerShell/CMD'yi) açın, dosyaları indirdiğiniz klasöre gidin (cd /klasorun/yolu) ve aşağıdaki komutları sırayla çalıştırın:

Modelfile'ı kullanarak 'kaira' adında yeni bir model oluşturun

ollama create kaira -f ./Modelfile

Tebrikler! Artık modelinizle sohbet edebilirsiniz

ollama run kaira

Artık kaira adıyla kaydedilen modelinizle doğrudan terminal üzerinden sohbet edebilirsiniz!

🧠 Model Detayları Taban Model: ytu-ce-cosmos/Turkish-Gemma-9b-T1 (Google Gemma 2 tabanlı)

Eğitim: Model, Türkçe anlama, talimat takip etme ve akıl yürütme yeteneklerini geliştirmek için çeşitli Türkçe veri setleri ile eğitilmiştir.

Kuantizasyon Formatı: GGUF - Q4_K_M. Bu 4-bit'lik kuantizasyon metodu, kalite ve performans arasında mükemmel bir denge sunar. Model yaklaşık 5.96 GB boyutundadır ve 8GB VRAM'e sahip çoğu modern GPU'da veya 16GB RAM'e sahip sistemlerde akıcı bir şekilde çalışır.

⚙️ Gelişmiş Kullanım: llama.cpp ile Manuel Çalıştırma Eğer Ollama kullanmak istemiyorsanız ve llama.cpp üzerinde tam kontrol sahibi olmak isterseniz, modeli aşağıdaki gibi manuel olarak çalıştırabilirsiniz.

llama.cpp Projesini Kurun

Resmi GitHub reposundan projenin son sürümünü indirip derleyin.

git clone https://github.com/ggerganov/llama.cpp

cd llama.cpp

NVIDIA GPU desteği için (önerilir):

make LLAMA_CUBLAS=1

Sadece CPU için:

make

Modeli Çalıştırın

llama.cpp klasörünün içindeyken aşağıdaki komutları kullanabilirsiniz.

GPU ile Çalıştırma (Örnek: 35 katman GPU'ya yükleniyor):

./main -m /path/to/kaira-turkish-gemma-9b-t1.Q4_K_M.gguf -n 512 --repeat-penalty 1.1 -ngl 35 -p "Antalya'da gezilecek 3 yer önerir misin?"

Sadece CPU ile Çalıştırma:

./main -m /path/to/kaira-turkish-gemma-9b-t1.Q4_K_M.gguf -n 512 --repeat-penalty 1.1 -p "Yapay zeka etiği hakkında kısa bir bilgi verir misin?"

Lisans

Bu model, taban model olan ytu-ce-cosmos/Turkish-Gemma-9b-T1'in lisansına tabidir. Gemma lisansı altında dağıtılmaktadır.

Teşekkür ve Atıf (Acknowledgements & Citation)

Bu projenin kalbi olan Turkish-Gemma-9b-T1 modelini eğiten ve açık bir şekilde toplulukla paylaşan Yıldız Teknik Üniversitesi Bilgisayar Mühendisliği Bölümü COSMOS ekibine en içten teşekkürler. Asıl bilimsel ve akademik çalışma onlara aittir.

Bu GGUF versiyonu, onların değerli çalışmalarını daha geniş kitlelerin erişimine sunma amacı taşımaktadır. Lütfen orijinal çalışmalarını ve modellerini destekleyin.

- Downloads last month

- 379

2-bit

3-bit

4-bit

16-bit

Model tree for umutkkgz/Kaira-Turkish-Gemma-9B-T1-GGUF

Base model

ytu-ce-cosmos/Turkish-Gemma-9b-T1